- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

Enquanto Fagulha suporta o carregamento arquivos de local sistema de arquivos, requer que o arquivos estão disponíveis no mesmo caminho em todos os nós do cluster. Alguns sistemas de arquivos de rede, como NFS, AFS e a camada NFS do MapR, são expostos ao usuário como um sistema de arquivos regular.

Posteriormente, também se pode perguntar: como executo o Spark no modo local?

No modo local , fagulha empregos corre em uma única máquina e são executados em paralelo usando multi-threading: isso restringe o paralelismo a (no máximo) o número de núcleos em sua máquina. Para corre empregos em modo local , você precisa primeiro reservar uma máquina através do SLURM no modo interativo modo e faça login nele.

Além disso, o que é SC textFile? arquivo de texto é um método de uma organização. apache. SparkContext classe que lê um arquivo de texto do HDFS, um sistema de arquivos local (disponível em todos os nós) ou qualquer URI de sistema de arquivos compatível com Hadoop e retorne-o como um RDD de Strings.

Nesse sentido, o que é um arquivo spark?

o Arquivo Spark é um documento onde você guarda todas as suas qualidades criativas. Foi definido pelo autor Stephen Johnson. Então, em vez de rabiscar em um Post-it® no meio da noite ou dedicar diferentes diários para ideias, você coloca todos os seus conceitos em um Arquivo.

O que é centelha de coleção paralelizada?

Descrevemos as operações em conjuntos de dados distribuídos posteriormente. Coleções paralelizadas são criados chamando o JavaSparkContext's paralelizar método em um existente Coleção em seu programa de driver. Os elementos do coleção são copiados para formar um conjunto de dados distribuído que pode ser operado em paralelo.

Recomendado:

O Python pode ler arquivos ZIP?

Para trabalhar em arquivos zip usando python, usaremos um módulo python embutido chamado zipfile. print ('Pronto!' ZipFile é uma classe do módulo zipfile para ler e escrever arquivos zip. Aqui importamos apenas a classe ZipFile do módulo zipfile

Finale pode ler arquivos PDF?

Dica de profissional: Você também pode abrir o arquivo noFinale selecionando o arquivo em seu localizador e clicando com o botão direito do mouse. Em seguida, selecione “Abrir com…” e escolha Finale na barra de programas. Parabéns! Você importou com sucesso um arquivo PDF para o Finale usando o ScanScore

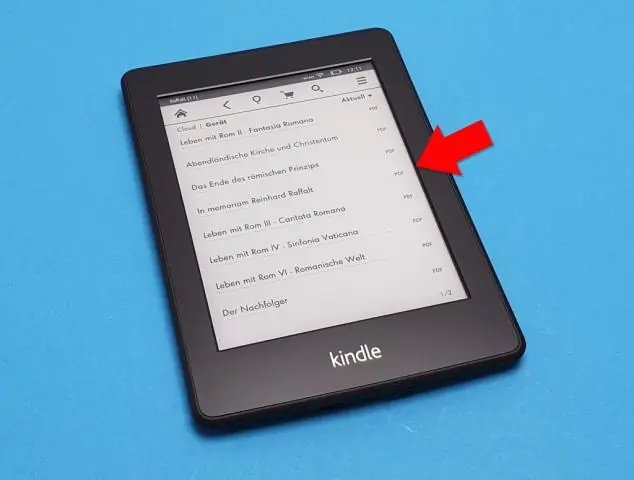

O Nook pode ler arquivos PDF?

Os documentos que você pode adicionar ao Nook incluem PDFs, que podem ser livros ou outros documentos mais curtos. Os PDFs no Nook podem ser lidos como qualquer outro livro comprado, e você pode sincronizar o dispositivo, copiando os documentos do seu computador para o Nook. Clique duas vezes na pasta "Livros" ou "Documentos" na unidade do seu Nook

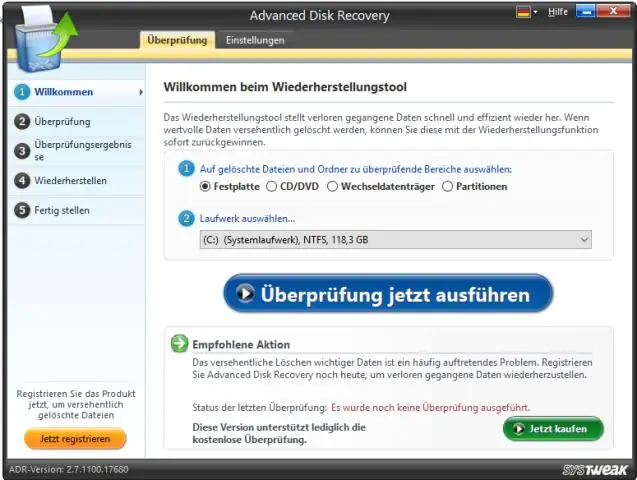

O Windows 10 pode ler arquivos brutos?

O Windows 10 não é fornecido com suporte nativo para a visualização de arquivos de imagem bruta, o que significa que os usuários não podem visualizar miniaturas ou metadados no Explorador de Arquivos do Windows do aplicativo Fotos. A Microsoft tem uma solução para fotógrafos que precisam desse recurso, no entanto, e é chamada de Raw Image Extension

É possível ler e gravar em locais aleatórios dentro de um arquivo usando Java?

Usando um arquivo de acesso aleatório, podemos ler de um arquivo, bem como gravar no arquivo. Ler e escrever usando os fluxos de entrada e saída do arquivo são um processo sequencial. Usando um arquivo de acesso aleatório, podemos ler ou escrever em qualquer posição dentro do arquivo. Um objeto da classe RandomAccessFile pode fazer o acesso aleatório ao arquivo