- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

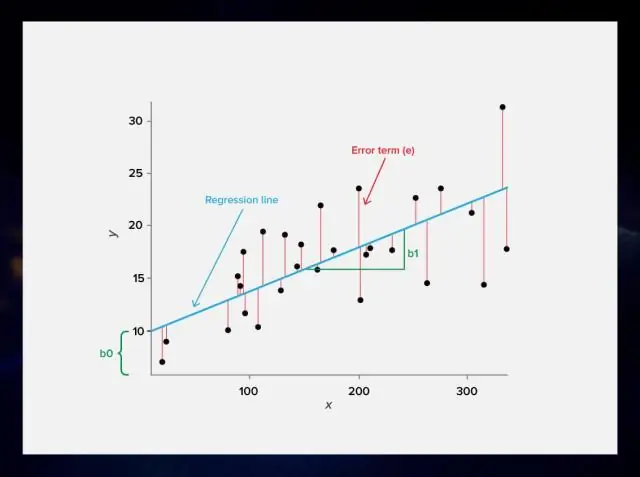

Regularização . Esta é uma forma de regressão , que restringe / regulariza ou reduz as estimativas de coeficiente para zero. Em outras palavras, esta técnica desestimula o aprendizado de uma forma mais complexa ou flexível modelo , de modo a evitar o risco de sobreajuste. Uma relação simples para regressão linear se parece com isso.

Correspondentemente, o que é lambda na regressão linear?

Quando temos um alto grau linear polinômio que é usado para ajustar um conjunto de pontos em um regressão linear configuração, para evitar overfitting, usamos regularização e incluímos um lambda parâmetro na função de custo. Esse lambda é então usado para atualizar os parâmetros theta no algoritmo de descida do gradiente.

Em segundo lugar, qual é o objetivo da regularização? Regularização é uma técnica usada para ajustar o função adicionando um termo de penalidade adicional no erro função . O termo adicional controla o excesso de flutuação função de forma que os coeficientes não assumam valores extremos.

Desta forma, por que precisamos regularizar na regressão?

O objetivo de regularização é evitar overfitting, em outras palavras nós estão tentando evitar modelos que se ajustam extremamente bem aos dados de treinamento (dados usados para construir o modelo), mas se ajustam mal aos dados de teste (dados usados para testar a qualidade do modelo). Isso é conhecido como overfitting.

O que significa regularização?

Em matemática, estatística e ciência da computação, especialmente em aprendizado de máquina e problemas inversos, regularização é o processo de adicionar informações para resolver um problema mal colocado ou para evitar sobreajuste. Regularização aplica-se a funções objetivo em problemas de otimização mal colocados.

Recomendado:

O que é linear e não linear na estrutura de dados?

1. Em uma estrutura de dados linear, os elementos de dados são organizados em uma ordem linear onde cada um dos elementos é anexado ao seu adjacente anterior e ao próximo. Em uma estrutura de dados não linear, os elementos de dados são anexados de maneira hierárquica. Na estrutura de dados linear, os elementos de dados podem ser percorridos em uma única execução

O que é regressão ML?

A regressão é um algoritmo de ML que pode ser treinado para prever saídas reais numeradas; como temperatura, preço das ações, etc. A regressão é baseada em uma hipótese que pode ser linear, quadrática, polinomial, não linear, etc. A hipótese é uma função que se baseia em alguns parâmetros ocultos e os valores de entrada

O que é o método de árvore de regressão?

A metodologia geral de construção de árvore de regressão permite que as variáveis de entrada sejam uma mistura de variáveis contínuas e categóricas. Uma árvore de regressão pode ser considerada uma variante das árvores de decisão, projetada para aproximar funções de valor real, em vez de ser usada para métodos de classificação

O que é um problema de regressão no aprendizado de máquina?

Um problema de regressão é quando a variável de saída é um valor real ou contínuo, como “salário” ou “peso”. Muitos modelos diferentes podem ser usados, o mais simples é a regressão linear. Tenta ajustar os dados com o melhor hiperplano que passa pelos pontos

O que é análise de árvore de regressão?

A análise da árvore de regressão é quando o resultado previsto pode ser considerado um número real (por exemplo, o preço de uma casa ou o tempo de permanência de um paciente em um hospital)