- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

Não, não é obrigatório aprender Hadoop Primeiro a aprender Spark mas conhecimento básico de Hadoop e o HDFS adicionará uma vantagem ao seu aprendizado de Fagulha . Fagulha é uma tecnologia emergente e um burburinho do mercado. Fagulha será benéfico para sua carreira como Fagulha os profissionais são mais preferidos na indústria.

Também saber é, o que é melhor Hadoop ou faísca?

Hadoop é projetado para lidar com o processamento em lote de forma eficiente, enquanto Fagulha foi projetado para lidar com dados em tempo real com eficiência. Hadoop é um framework de computação de alta latência, que não tem um modo interativo, enquanto Fagulha é uma computação de baixa latência e pode processar dados de forma ativa.

Além do mais, o spark é melhor do que o MapReduce? Diferença chave entre MapReduce vs Apache Spark MapReduce é estritamente baseado em disco, enquanto o Apache Fagulha usa memória e pode usar um disco para processamento. Fagulha é capaz de executar trabalhos de processamento em lote de 10 a 100 vezes mais rápido que a MapReduce Embora ambas as ferramentas sejam usadas para processar Big Data.

Posteriormente, a questão é: é necessário aprender Hadoop para o spark?

Nao voce nao precisa aprender Hadoop para learnSpark . Fagulha foi um projeto independente. Mas depois de YARNand Hadoop 2.0, Fagulha tornou-se popular porque Fagulha pode ser executado em cima do HDFS junto com outros Hadoop componentes. Hadoop é uma estrutura na qual você escreve um trabalho de MapReduce herdando classes Java.

Vale a pena aprender o Apache Spark?

1) Aprenda Apache Spark para ter acesso ampliado ao Big Data, os cientistas estão demonstrando interesse em trabalhar com Fagulha devido à sua capacidade de armazenar dados residentes na memória que ajuda a acelerar a máquina Aprendendo cargas de trabalho ao contrário do Hadoop MapReduce.

Recomendado:

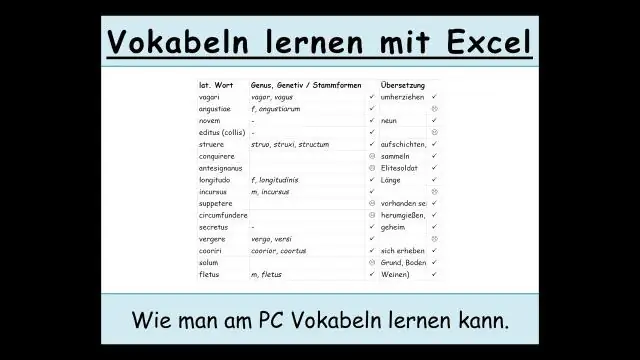

Qual é a melhor maneira de aprender Excel?

5 dicas para aprender Excel Pratique problemas matemáticos simples no Excel. Quando se trata de Excel, é mais fácil começar com a matemática básica. Aprenda a criar tabelas. Aprenda a criar gráficos. Faça os cursos de treinamento do Excel. Obtenha uma Certificação de Especialista em Microsoft Office

Qual é o melhor site para aprender selênio?

Também a seguir estão alguns dos cursos gratuitos disponíveis para aprender on-line sempre que quiser. A ajuda de teste de software oferece alguns bons tutoriais sobre Selenium. java-for-selenium.blogspot.inJava-For-Selenium Isso o ajudará a aprender o Core Java necessário para aprender Java e também automação do Selenium

Qual é a melhor maneira de aprender Python gratuitamente?

Por precaução, se você tiver qualquer outro site útil em Python que ensine o desenvolvimento em Python gratuitamente, sinta-se à vontade para sugerir. CodeCademy. Se você gosta de aprendizado interativo, não há lugar melhor do que Codecademy. Udemy. Classe Python do Google. Curso de Python grátis da Microsoft. Coursera

Qual é o melhor app para aprender outro idioma?

Melhores aplicativos de aprendizagem de línguas LinguaLift. Este é um aplicativo de idioma voltado mais para alunos sérios que desejam um programa de idioma completo com a orientação de um tutor. Duolingo. HelloTalk. Mindsnacks. Busuu. Babbel. TripLingo. MosaLingua

Qual é o melhor aplicativo para aprender?

Os melhores aplicativos gratuitos de aprendizagem de línguas para o Duolingo 2019. Resumindo: Duolingo é o melhor programa de aprendizado de idiomas on-line gratuito. Memrise. Conclusão: O aplicativo de estudo Freemium Memrise tem um rico conteúdo em línguas estrangeiras, bem como em outros assuntos. Quizlet. busuu. Beelinguapp. 50 idiomas. HelloTalk. TinyCards by Duolingo