- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

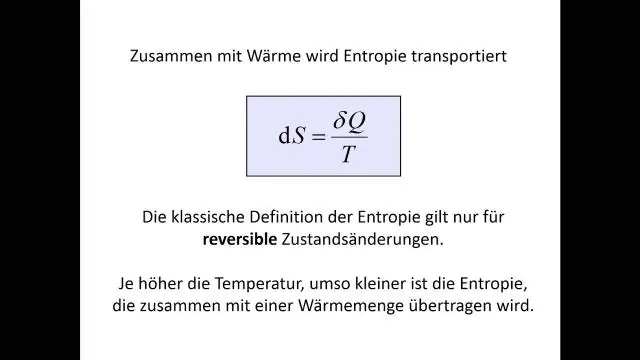

Ganho de informação = quanto Entropia nós removemos, então

Isso faz sentido: superior Ganho de informação = mais Entropia removido, que é o que queremos. No caso perfeito, cada ramo conteria apenas uma cor após a divisão, que seria zero entropia !

Além disso, o que é ganho de informação e entropia na árvore de decisão?

Ganho de informação : O ganho de informação é baseado na diminuição em entropia depois que um conjunto de dados é dividido em um atributo. Construindo um árvore de decisão trata-se de encontrar o atributo que retorna o maior ganho de informação (ou seja, os ramos mais homogêneos). Etapa 1: Calcular entropia do alvo.

Da mesma forma, o que é entropia nos dados? Em formação entropia é a taxa média na qual a informação é produzida por uma fonte estocástica de dados . A medida da informação entropia associado a cada possível dados valor é o logaritmo negativo da função de massa de probabilidade para o valor: onde é a expectativa definida pela probabilidade.

Nesse sentido, o que significa ganho de informação?

Ganho de informação calcula a redução na entropia ou surpresa ao transformar um conjunto de dados de alguma forma. Ganho de informação é a redução da entropia ou surpresa pela transformação de um conjunto de dados e é frequentemente usado em árvores de decisão de treinamento.

Qual é a definição de entropia na árvore de decisão?

Definição : Entropia são as medidas de impureza, desordem ou incerteza em um monte de exemplos.

Recomendado:

O que é telecomunicação em tecnologia da informação?

As telecomunicações são os meios de transmissão eletrônica de informações à distância. As informações podem ser na forma de chamadas telefônicas de voz, dados, texto, imagens ou vídeo. Hoje, as telecomunicações são usadas para organizar sistemas de computador mais ou menos remotos em redes de telecomunicações

Qual é a definição de entropia na árvore de decisão?

Entropia: uma árvore de decisão é construída de cima para baixo a partir de um nó raiz e envolve o particionamento dos dados em subconjuntos que contêm instâncias com valores semelhantes (homogêneos). O algoritmo ID3 usa entropia para calcular a homogeneidade de uma amostra

O que é tecnologia da informação no sistema de informação gerencial?

O sistema de informações de gerenciamento (MIS) se refere a uma grande infraestrutura usada por uma empresa ou corporação, enquanto a tecnologia da informação (TI) é um componente dessa infraestrutura que é usado para coletar e transmitir dados. A Tecnologia da Informação apóia e facilita o emprego desse sistema

O que é ganho em um amplificador?

Na eletrônica, o ganho é uma medida da capacidade de um circuito de duas portas (geralmente um amplificador) de aumentar a potência ou a amplitude de um sinal da porta de entrada para a de saída adicionando energia convertida de alguma fonte de alimentação ao sinal. Muitas vezes é expresso usando as unidades logarítmicas de decibéis (dB) ('dB ganho')

O que é entropia na mineração de texto?

Entropia é definida como: Entropia é a soma da probabilidade de cada rótulo vezes a probabilidade de log desse mesmo rótulo. Como posso aplicar entropia e entropia máxima em termos de mineração de texto?