- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

Lata de faísca ser corre usando o agendador de cluster autônomo integrado no local modo. Isso significa que todos os Fagulha processos são corre dentro da mesma JVM, efetivamente, uma única instância multithread de Fagulha.

A este respeito, como executo o Apache Spark localmente?

As etapas a seguir mostram como instalar o Apache Spark

- Etapa 1: Verificando a instalação do Java.

- Etapa 2: Verificando a instalação do Scala.

- Etapa 3: Baixando Scala.

- Etapa 4: Instalando o Scala.

- Etapa 5: baixando o Apache Spark.

- Etapa 6: Instalando o Spark.

- Etapa 7: Verificando a instalação do Spark.

Além disso, podemos executar o Spark sem Hadoop? Conforme Fagulha documentação, O Spark pode ser executado sem Hadoop . Vocês poderia executá-lo como um modo autônomo sem qualquer gerenciador de recursos. Mas se tu quer corre na configuração de vários nós, tu precisa de um gerenciador de recursos como YARN ou Mesos e um sistema de arquivos distribuído como HDFS , S3 etc. Sim, faísca pode correr sem hadoop.

Além do acima, como executo o Spark no modo autônomo?

Para instalar Modo autônomo do Spark , você simplesmente coloca uma versão compilada de Fagulha em cada nó do cluster. Você pode obter versões pré-construídas de Fagulha com cada lançamento ou construa você mesmo.

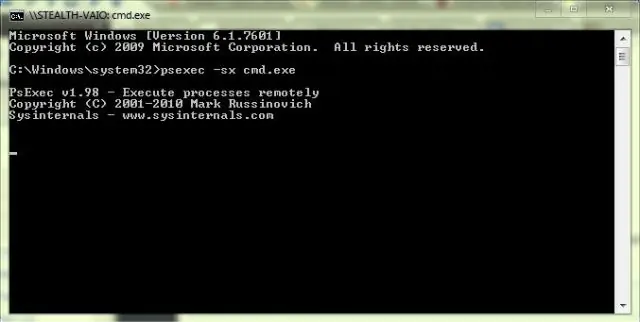

O Spark pode rodar no Windows?

UMA Fagulha aplicativo posso seja um janelas - script shell ou isso posso ser um programa personalizado escrito em Java, Scala, Python ou R. Você precisa janelas executáveis instalados em seu sistema para corre esses aplicativos.

Recomendado:

Como posso executar meu programa C no prompt de comando?

Como compilar um programa C no prompt de comando? Execute o comando 'gcc -v' para verificar se você tem um compilador instalado. Crie um programa c e armazene-o em seu sistema. Mude o diretório de trabalho para onde você tem seu Cprogram. Exemplo:> cd Desktop. A próxima etapa é compilar o programa. Na próxima etapa, podemos executar o programa

Posso executar o Windows e o Mac no mesmo PC?

Se você possui um Mac baseado em Intel, pode executar o OS X e o Windows no mesmo computador. A maioria dos computadores PC usa chips baseados em Intel, o que significa que agora você pode executar os sistemas operacionais Windows e OS X em um computador Mac

O LastPass pode armazenar senhas localmente?

Seus dados do LastPass Vault (por exemplo, URLs, nomes de usuário e senhas de sites, notas seguras, itens de preenchimento de formulário) são armazenados localmente em seu computador, e a localização de armazenamento depende do (s) sistema (s) operacional (is) e navegador (es) da web que você usa

Posso executar Python no Hadoop?

Com uma escolha entre linguagens de programação como Java, Scala e Python para ecossistema Hadoop, a maioria dos desenvolvedores usa Python por causa de suas bibliotecas de suporte para tarefas de análise de dados. O streaming do Hadoop permite ao usuário criar e executar tarefas Mapear / Reduzir com qualquer script ou executável como mapeador e / ou redutor

O que é armazenamento conectado localmente?

DAS é a abreviação de armazenamento de conexão direta. Armazenamento de conexão direta (DAS), também chamado de armazenamento de conexão direta, é o armazenamento digital conectado diretamente a um computador ou servidor. Em outras palavras, o DAS não faz parte de uma rede de armazenamento. O exemplo mais familiar de DAS é o disco rígido interno em um laptop ou PC desktop