- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

Em termos leigos, o auto - atenção mecanismo permite que as entradas interajam entre si (“ auto ”) E descubra quem eles devem pagar mais atenção para ( atenção ”). As saídas estão agregados dessas interações e atenção pontuações.

Além disso, o que é autoatenção?

Auto - atenção , às vezes chamado de intra- atenção é um atenção mecanismo relacionando diferentes posições de uma única sequência, a fim de computar uma representação da sequência.

Além disso, o que é auto-atenção no aprendizado profundo? Primeiro, vamos definir o que “ auto - Atenção é. Cheng et al, em seu artigo denominado “Long Short-Term Memory-Networks for Máquina Reading”, definido auto - Atenção como o mecanismo de relacionar diferentes posições de uma única sequência ou frase para obter uma representação mais vívida.

Em relação a isso, o que é mecanismo de Atenção?

Mecanismo de Atenção permite que o decodificador atenda a diferentes partes da sentença fonte em cada etapa da geração de saída. Em vez de codificar a sequência de entrada em um único vetor de contexto fixo, deixamos o modelo aprender como gerar um vetor de contexto para cada etapa de tempo de saída.

O que é o modelo baseado em atenção?

Atenção - modelos baseados pertencem a uma classe de modelos comumente chamado de sequência a sequência modelos . O objetivo destes modelos , como o nome sugere, para produzir uma seqüência de saída dada uma seqüência de entrada que são, em geral, de comprimentos diferentes.

Recomendado:

Como funciona o proxy Spring AOP?

Proxy AOP: um objeto criado pelo framework AOP para implementar os contratos de aspecto (aconselhar execuções de métodos e assim por diante). No Spring Framework, um proxy AOP será um proxy JDK dinâmico ou um proxy CGLIB. Tecelagem: vinculando aspectos com outros tipos de aplicativos ou objetos para criar um objeto aconselhado

Como funciona uma TV espelho?

Uma TV espelho consiste em um espelho especial semitransparente com uma TV LCD atrás da superfície espelhada. O espelho é cuidadosamente polarizado para permitir que uma imagem seja transferida através do espelho, de forma que, quando a TV estiver desligada, o dispositivo se pareça com um espelho

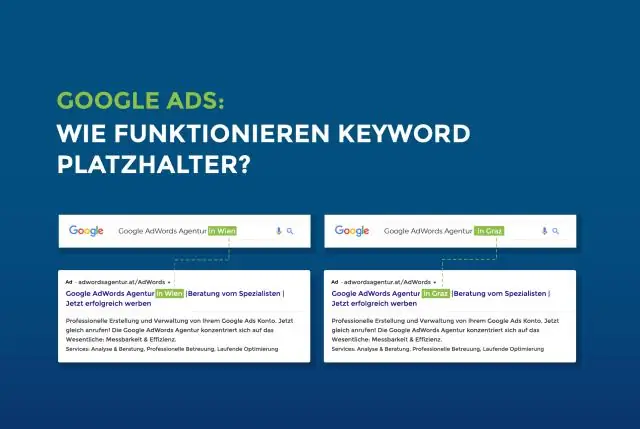

Como funciona o placeholder?

O atributo placeholder especifica uma pequena dica que descreve o valor esperado de um campo de entrada (por exemplo, um valor de amostra ou uma breve descrição do formato esperado). Observação: o atributo placeholder funciona com os seguintes tipos de entrada: texto, pesquisa, url, telefone, e-mail e senha

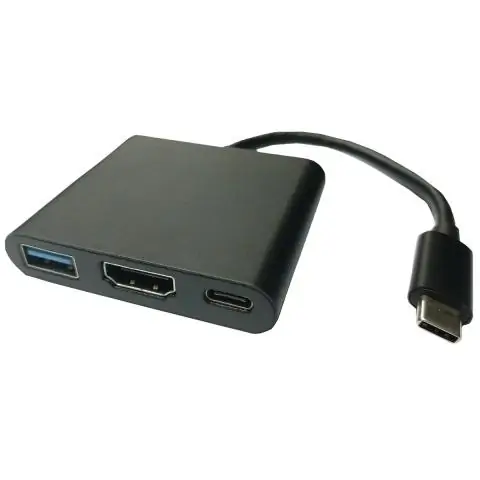

Como funciona um adaptador de vídeo USB?

Adaptadores de vídeo USB são dispositivos que usam uma porta USB e vão para uma ou mais conexões de vídeo, como VGA, DVI, HDMI ou DisplayPort. Isso é útil se você gostaria de adicionar um monitor adicional à configuração do seu computador, mas está sem conexões de vídeo no seu computador

Como funciona o código de correção de erros?

Um código de correção de erros é um algoritmo para expressar uma sequência de números de forma que quaisquer erros introduzidos possam ser detectados e corrigidos (dentro de certas limitações) com base nos números restantes. O estudo dos códigos de correção de erros e da matemática associada é conhecido como teoria da codificação