- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Última modificação 2025-01-22 17:37.

Fagulha roda em Java 8+, Pitão 2.7 + / 3.4 + e R 3.1+. Para a API Scala, Fagulha 2.3. 0 usa Scala 2.11. Você vai precisar usar um Scala compatível versão (2.11.

Da mesma forma, o spark funciona com o Python 3?

Apache Fagulha é uma estrutura de computação em cluster, atualmente uma das mais ativamente desenvolvidas na área de Big Data de código aberto. Desde a última versão 1.4 (junho de 2015), Fagulha suporta R e Python 3 (para complementar o suporte previamente disponível para Java, Scala e Pitão 2).

Além disso, como altero a versão do Spark do Python? Caso você só queira mudança a versão python para a tarefa atual, você pode usar o seguinte comando pyspark start: PYSPARK_DRIVER_PYTHON = / home / user1 / anaconda2 / bin / Pitão PYSPARK_PYTHON = / usr / local / anaconda2 / bin / Pitão pyspark --master..

Além disso, qual é a última versão do Spark?

Apache Spark

| Autor (es) original (is) | Matei Zaharia |

|---|---|

| lançamento inicial | 26 de maio de 2014 |

| Versão estável | 2.4.5 / 8 de fevereiro de 2020 |

| Repositório | Repositório Spark |

| Escrito em | Scala |

O que é faísca Python?

Controlando Big Data com Apache Fagulha e Pitão Py4J é uma biblioteca popularmente integrada dentro PySpark que permite Pitão interface dinamicamente com objetos JVM (RDDs). Apache Fagulha vem com um shell interativo para Pitão como faz para Scala. A concha para Pitão é conhecido como PySpark ”.

Recomendado:

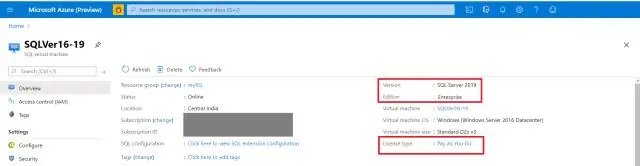

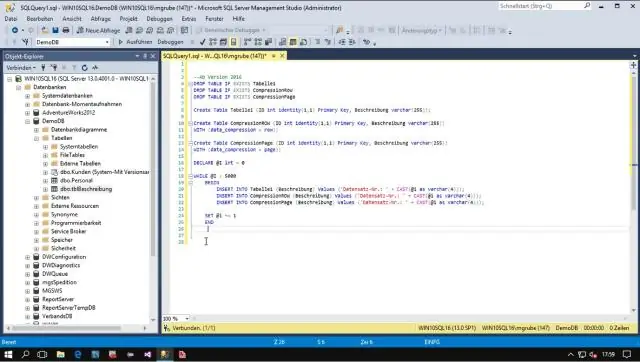

Qual é a minha versão do SQL Server?

A primeira é usando Enterprise Manager ou SQL Server Management Studio e clicando com o botão direito do mouse no nome da instância e selecionando Propriedades. Na seção geral, você verá informações como nas capturas de tela a seguir. A 'versão do produto' ou 'versão' fornece um número da versão que está instalada

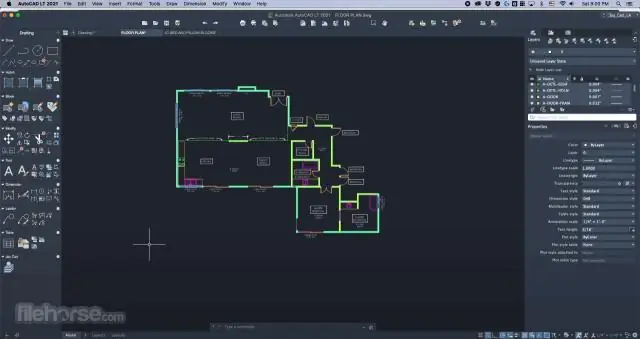

Qual é a versão mais recente do AutoCAD?

AutoCAD 2019

Qual é a versão atual da primavera?

Spring Framework 4.3 foi lançado em 10 de junho de 2016 e terá suporte até 2020. Será a última geração dentro dos requisitos gerais do sistema Spring 4 (Java 6+, Servlet 2.5+), [] '. O Spring 5 foi anunciado para ser construído sobre Reactive Streams compatível com Reactor Core

Qual versão do SQL Server o Azure usa?

A resposta é não. Esse número é diferente de uma instância local do SQL Server. Pelo que tenho preparado, a versão 12.0 é a versão mais atual. Considerando a instância do Azure e o SQL Server 2014 de uma versão do produto 12.0, agora se resume ao nível de compatibilidade para os bancos de dados do Azure

Qual versão do Java o gradle usa?

O Gradle só pode ser executado no Java versão 8 ou superior. O Gradle ainda oferece suporte à compilação, teste, geração de Javadoc e execução de aplicativos para Java 6 e Java 7